Künstliche Intelligenz

„Wir arbeiten mit gefährlichen Dingen“- Ex-Google-Manager warnt vor KI-generiertem Virus

Ein ehemaliger Google-Manager, der als Pionier auf dem Gebiet der Künstlichen Intelligenz gilt, äußert ernste Bedenken über die weitreichende Verfügbarkeit von KI-Tools. Seine Horrorvision für die Zukunft: KI wird dazu verwendet, ein künstlich generiertes Super-Virus zu erschaffen.

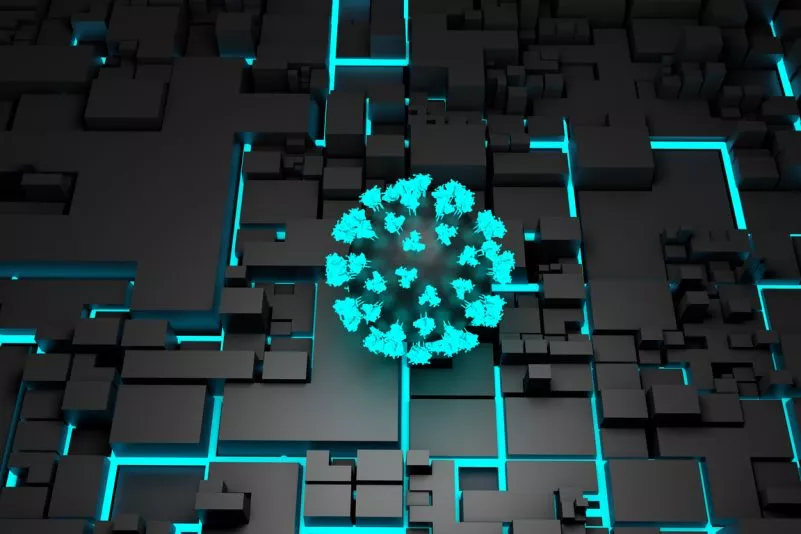

KI-generiertes Virus mit unkalkulierbarer Wirkung.

Foto: IStock: Design Cells

Mustafa Suleyman, Mitbegründer von Google DeepMind, äußerte die Bedenken während eines Podcast-Interviews. Der KI-Pionier ging der Frage nach, wie gefährlich es werden könnte, wenn KI in die synthetische Herstellung von Viren einbezogen wird. Suleyman warnte in dem Zuge vor den Konsequenzen eines zu einfachen Zugangs zu KI-basierten Software-Tools für jedermann. Es bestehe die Gefahr, dass künstliche Intelligenz missbraucht werden könnte, um im Labor ein äußerst schädliches Virus zu erschaffen.

Gefahr für Menschheit: Technologie trifft auf Biologie

Als Interviewgast im Podcast „The Diary of a CEO“ malte der Ex-Google-Manager Suleyman ein düsteres Zukunftsbild: Eine Welt, in der KI-Systeme synthetische Krankheitserreger entwickeln, die übertragbarer und tödlicher sind als alles, was die Natur jemals hervorgebracht hat. Laut Suleyman ist dies eine potenzielle Realität, der wir uns möglicherweise stellen müssen: „Das düsterste Szenario ist, dass Menschen mit Pathogenen experimentieren, künstlich hergestellten synthetischen Pathogenen, die am Ende aus Versehen oder auch absichtlich besser übertragbar werden.“

So wie Künstliche Intelligenz zur Optimierung von Arbeitsprozessen oder Programmiercodes verwendet werden kann, könnten KI-Tools auch dafür genutzt werden, die Effektivität eines Krankheitserregers so zu maximieren, dass er zu einer Gefahr für die Menschheit wird.

Missbrauchspotenzial durch „KI für jedermann“

Das Hauptproblem für Suleyman: die Demokratisierung der KI-Technologie. Mit einem besseren und breitflächigen Zugang zu fortschrittlichen KI-Tools steige das Missbrauchspotenzial exponentiell. Aktuell können zu viele Menschen zu unkontrolliert KI-Technologie nutzen. „Wir arbeiten mit gefährlichen Dingen“, so Suleyman. „Wir können nicht einfach alle darauf Zugriff haben lassen. Wir müssen limitieren, wer KI-Software, Cloud-Systeme und sogar manche biologischen Materialien nutzen kann.“

Suleyman plädiert für eine „Strategie der Eindämmung“ der Künstlichen Intelligenz, die er mit der Strategie der NATO für Atomwaffen vergleicht. Der Zugang zu KI-Tools müsse eingeschränkt werden und eine stärkere Regulierung durch die Politik erfolgen. Fraglich ist, ob die politischen Prozesse, die den Umgang mit KI künftig zu regeln haben, mit der rasend schnellen Entwicklung der Technologie mithalten können.

Warnungen aus der KI-Community

Ende Oktober wird Suleyman an einem KI-Gipfel in Washington, D.C. teilnehmen, zu dem auch OpenAI-Gründer Sam Altman, Meta-Chef Mark Zuckerberg, Sundar Pichai von Alphabet und auch Elon Musk erwartet werden. Der Besitzer von X, vormals Twitter, und Chef des Elektroautobauers Tesla war Mitbegründer von OpenAI, des Startups, das ChatGPT entwickelt hat. Elon Musk hat ein neues Unternehmen rund um Künstliche Intelligenz (KI) gegründet. Es heißt „X.AI“ und soll ChatGPT Konkurrenz machen.

Obwohl es auch eins der Geschäftsfelder von Musk ist, hat dieser schon mehrfach vor der Gefahr durch Künstliche Intelligenz gewarnt. So war der 51-Jährige auch – der wohl prominenteste – Mitunterzeichner eines offenen Briefes mit dem Titel „Stoppt alle großen KI-Experimente“, in dem im Frühjahr 2023 mehr als 1.000 Unterzeichner aus Wissenschaft und Wirtschaft vor den Folgen von sich rasant verbreitender Künstlicher Intelligenz warnten. Die Befürchtung ist, dass Systeme Künstlicher Intelligenz zu mächtig und somit zu einer Gefahr für die Menschheit werden könnten. In dem Brief wurden alle entsprechenden Labore aufgefordert, die Entwicklung von KI-Systemen für mindestens sechs Monate zu stoppen, um in dieser Zeit gemeinsam mit unabhängigen Experten Sicherheitsprotokolle zu entwickeln und umzusetzen.

Lydia Roeber hat sich schon ihr Studium an der FU Berlin mit Texten verdient und lange als Fernsehjournalistin gearbeitet. Früher als Reisejournalistin tätig, nimmt sie sich heute bevorzugt die drängenden gesellschaftlichen Themen bei Epoch Times vor – von Transhumanismus über digitale Kontrolle bis zum Bildungsnotstand.

Aktuelle Artikel der Autorin

16. Oktober 2025

Was passiert, wenn China Seltene Erden nicht mehr liefert?

12. Oktober 2025

Mit Natur besser lernen: Die Schule als Garten des Denkens

Kommentare

Noch keine Kommentare – schreiben Sie den ersten Kommentar zu diesem Artikel.

0

Kommentare

Noch keine Kommentare – schreiben Sie den ersten Kommentar zu diesem Artikel.